Modélisez vos entrepôts en équipe, obtenez un référentiel de connaissance

La modélisation des données reste un pilier incontournable des projets décisionnels, même à l’ère du Big Data et des Data Lakes. Trop souvent négligée, elle permet pourtant de garantir la qualité, la cohérence et l’exploitation des données par toutes les équipes. Aujourd’hui, de nouveaux outils collaboratifs de metadata management et de data governance offrent un cadre plus efficace que les tableurs et les diagrammes statiques. En centralisant la connaissance et en rendant le travail collectif, ils évitent le risque du « Data Swamp » et accélèrent la mise à disposition de données fiables pour l’ensemble de l’entreprise.

Pourquoi la modélisation des données reste essentielle

La modélisation décisionnelle est l’étape qui consiste à traduire dans la structure informatique les liens entre toutes les données : granularité, volumétrie, capacité de croisement, etc. Elle assure :

- un système d’information robuste et performant,

- une maintenance facilitée pour les équipes IT,

- une exploitation fluide pour les utilisateurs métiers.

Avec l’essor des Data Lakes, certaines entreprises ont cru pouvoir s’affranchir de cette discipline. Résultat : de nombreux lacs de données se sont transformés en véritables Data Swamps, difficiles à exploiter et coûteux à maintenir.

La conclusion est claire : sans gouvernance des données et sans modélisation structurée, la valeur business des données s’érode rapidement.

Des méthodes éprouvées mais souvent mal exploitées

Les méthodes OLAP et ses déclinaisons (ROLAP, MOLAP…), popularisées notamment par Ralph Kimball, restent des références dans le monde de la Business Intelligence. Cependant, leur mise en œuvre souffre encore de plusieurs limites :

- Processus souvent individuel (un concepteur impose sa vision).

- Connaissance rarement partagée ou centralisée.

- Difficulté à maintenir une cohérence entre les équipes.

Résultat : les modèles reflètent parfois plus la compréhension d’un individu que la réalité métier, ce qui réduit leur valeur collaborative.

Bonne pratiques pour développer et maintenir vos data products

Dans ce guide, nous vous proposons une présentation complète afin de vous aider à faire face aux complexités du développement et du maintien de data products.

Téléchargez le livre blancLes limites des outils traditionnels

Pendant longtemps, les outils de modélisation ont freiné l’adoption d’une approche réellement collaborative :

- Tableurs : absence de représentation graphique intuitive.

- PowerPoint ou diagrammes statiques : impossibles à maintenir à jour.

- Outils spécifiques de bases de données : cloisonnés et non collaboratifs.

Ces pratiques ne permettent pas de créer un référentiel de connaissance partagé ni de s’adapter aux évolutions rapides des données.

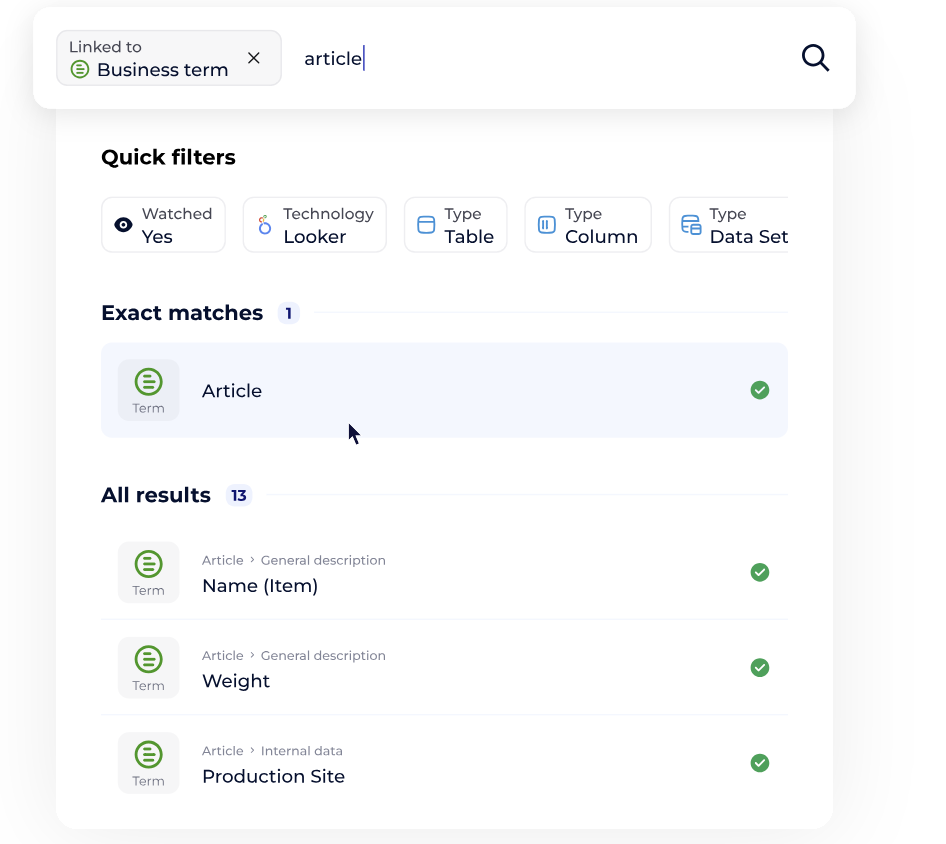

Le rôle clé des outils de Metadata Management

Les plateformes modernes de metadata management apportent une réponse concrète aux limites des approches classiques. Elles permettent :

- La centralisation des connaissances dans un référentiel unique.

- Une collaboration en temps réel entre métiers et IT.

- La traçabilité des données grâce au data lineage (origine, transformations, usages).

- L’automatisation de tâches complexes comme le reverse-engineering des bases existantes.

En connectant data mapping et data modeling, elles facilitent l’intégration avec les flux ETL/ELT et les outils de restitution.

C’est précisément dans cette optique que des plateformes comme DataGalaxy positionnent la modélisation au cœur de la Data & AI Product Governance : un travail collectif, documenté et aligné avec la stratégie data globale.

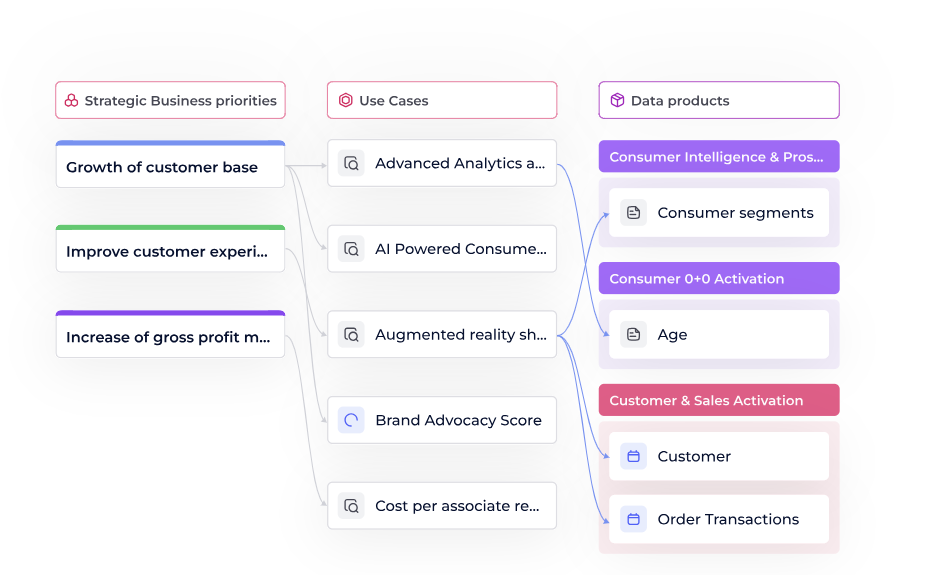

Modéliser, c’est gouverner les données

La modélisation n’est plus une simple étape technique : c’est un levier de gouvernance des données. Elle garantit que toutes les équipes parlent le même langage et utilisent des définitions cohérentes.

Cela s’inscrit dans une approche plus large de data governance framework, qui vise à aligner les usages métiers, la conformité réglementaire (ex. RGPD, HIPAA) et les innovations technologiques.

FAQ

- La modélisation est-elle encore utile avec l’IA et le Big Data ?

-

Oui. Même si les technologies modernes offrent plus de flexibilité, sans modélisation, les données deviennent rapidement ingérables. L’IA elle-même a besoin de données propres, structurées et contextualisées.

- Quelle est la différence entre Data Modeling et Data Mapping ?

-

Data Modeling définit la structure logique et relationnelle des données.

Data Mapping établit la correspondance entre sources et cibles (utile pour les flux ETL/ELT).Les deux sont complémentaires et doivent être alignés via un référentiel partagé.

- Quels sont les bénéfices concrets d’un outil de metadata management ?

-

Gain de temps grâce à la documentation automatique.

Réduction des erreurs et incohérences.

Collaboration renforcée entre équipes métiers, IT et data.

Points clés à retenir

- La modélisation des données reste un pilier stratégique pour éviter les dérives des Data Lakes.

- Les méthodes classiques (OLAP, Kimball) restent pertinentes, mais nécessitent des outils adaptés.

- Les plateformes de metadata management apportent un référentiel collaboratif et automatisent les tâches critiques.

- Modéliser, c’est aussi gouverner : cette pratique s’inscrit au cœur de la stratégie de gouvernance des données.