Flux ETL : un levier clé pour réussir vos projets BI

Dans un contexte où les organisations cherchent à être toujours plus agiles et efficaces, les projets de Business Intelligence (BI) ne peuvent réussir sans une gouvernance solide de leurs flux de données. Les flux ETL, qui orchestrent l’extraction, la transformation et le chargement des données, sont un levier clé pour garantir la fiabilité et la valeur du système décisionnel.

Résumé introductif

Les flux ETL (Extract, Transform, Load) constituent la colonne vertébrale des projets de Business Intelligence. Bien spécifiés et gérés, ils assurent la qualité, la fiabilité et la traçabilité des données utilisées dans vos analyses. À l’inverse, une mauvaise gouvernance entraîne silos, incohérences et perte de productivité. Cet article explore pourquoi les flux ETL sont cruciaux, comment les spécifier efficacement, et quels outils modernes permettent de dépasser les limites des approches « old school ».

Qu’est-ce qu’un flux ETL et pourquoi est-il stratégique ?

Un flux ETL (Extract, Transform, Load) désigne l’ensemble des processus permettant :

- Extraire les données de différentes sources (ERP, CRM, fichiers plats, APIs, etc.).

- Transformer ces données pour les nettoyer, harmoniser et enrichir.

- Charger les données dans un entrepôt ou un data lake afin de les rendre exploitables.

Sans flux ETL robustes, les projets BI se heurtent à des problèmes de qualité, de duplication et d’incohérence, compromettant ainsi la confiance des métiers dans la donnée.

Les limites des approches “old school”

Historiquement, la spécification des flux ETL reposait sur des outils rudimentaires : fichiers Excel, échanges par email, documentation fragmentée. Ces méthodes généraient plusieurs problèmes :

- Multiplication de versions contradictoires.

- Difficultés de traçabilité et de mise à jour.

- Manque de vision d’ensemble et de gouvernance des métadonnées.

- Risques élevés d’erreurs humaines.

Résultat : un travail long, coûteux et peu agile, en particulier lorsque les systèmes sources évoluent rapidement

Data Mapping et spécification des flux ETL

La première étape clé est le data mapping : définir précisément les correspondances entre les données sources et les cibles. C’est un exercice complexe qui nécessite :

- Une vision claire des objets métiers et techniques.

- Une gestion des changements et versions (notamment lors des évolutions des systèmes).

- Une gouvernance des métadonnées intégrée.

Un simple tableur atteint vite ses limites, surtout face aux flux complexes « n-n » où plusieurs colonnes sources alimentent plusieurs cibles.

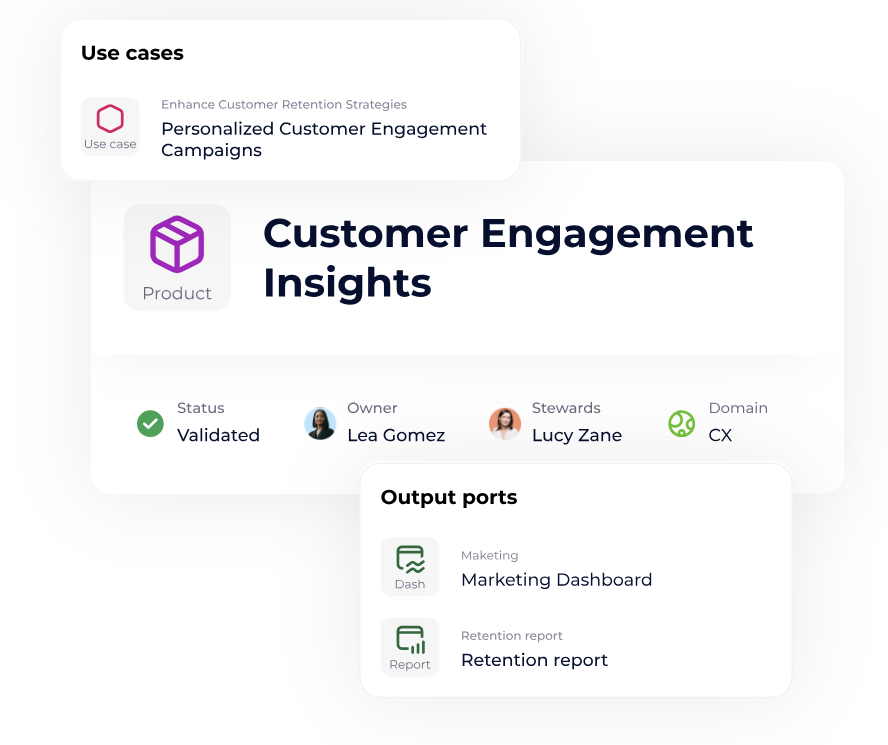

Bonne pratiques pour développer et maintenir vos data products

Dans ce guide, nous vous proposons une présentation complète afin de vous aider à faire face aux complexités du développement et du maintien de data products.

Téléchargez le livre blancLes outils modernes au service des flux ETL

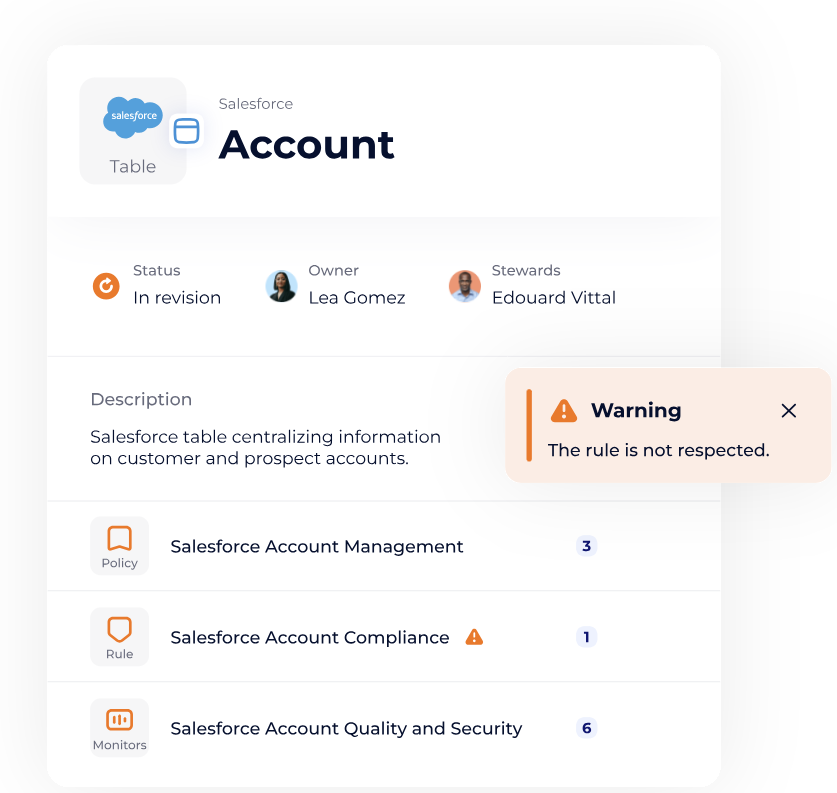

Aujourd’hui, les plateformes de Metadata Management et de Data Governance apportent une réponse adaptée :

- Centralisation des définitions et règles de transformation.

- Glossaire et dictionnaire de données pour partager un langage commun.

- Traçabilité et lineage afin de suivre l’origine et l’évolution des données.

- Collaboration entre métiers, AMOA et équipes techniques.

Des solutions comme DataGalaxy permettent d’orchestrer cette gouvernance, d’assurer la qualité et la transparence des flux ETL, et donc de maximiser le ROI des projets BI. À ce titre, des experts comme DBT Labs recommandent de suivre des bonnes pratiques ETL pour fiabiliser vos workflows de données

Flux ETL et gouvernance des données

Un projet BI réussi ne se limite pas à des choix techniques. Il repose aussi sur une approche de gouvernance :

- Définir un périmètre partagé entre métiers et IT.

- Établir des règles claires de transformation et de qualité.

- Mettre en place des processus de versioning et de documentation vivante.

- Suivre les impacts via des outils d’analyse d’impact et de lineage.

Cette approche fait des flux ETL un vecteur de transparence et de confiance dans la donnée.

FAQ

- Qu’est-ce qu’un flux ETL ?

-

Un flux ETL (Extract, Transform, Load) est un processus automatisé qui permet d’extraire des données depuis différentes sources, de les transformer pour les rendre exploitables, puis de les charger dans un entrepôt ou un système décisionnel. C’est un élément central des projets BI car il garantit la cohérence, la qualité et la disponibilité des données.

- Quelle est la différence entre ETL et ELT ?

-

L’ETL applique les transformations avant de charger les données, tandis que l’ELT (Extract, Load, Transform) les charge d’abord dans un data warehouse moderne (souvent cloud) puis applique les transformations directement dans cet environnement. L’ETL reste pertinent pour des architectures BI classiques, mais l’ELT est privilégié pour les plateformes cloud scalables comme Snowflake ou BigQuery.

- Pourquoi les flux ETL sont-ils essentiels en gouvernance des données ?

-

Les flux ETL permettent d’assurer la traçabilité, la qualité et la conformité des données utilisées dans la BI. Bien documentés et centralisés, ils évitent les erreurs liées aux fichiers Excel dispersés et garantissent que chaque indicateur repose sur une source fiable et validée par la gouvernance des données.

- Quels outils utiliser pour créer et gérer des flux ETL ?

-

Il existe de nombreux outils ETL, allant des solutions open-source comme Talend ou Apache NiFi, aux plateformes cloud comme AWS Glue, Azure Data Factory ou Google Dataflow. Le choix dépend du volume de données, des compétences internes et du besoin d’intégration avec d’autres briques de la gouvernance (catalogue, lineage, data quality).

- Comment documenter efficacement ses flux ETL ?

-

La meilleure pratique consiste à centraliser la description des flux ETL dans un outil de metadata management ou un data catalog. Cela permet d’avoir une vue claire sur l’origine des données, les transformations appliquées et leur usage final dans les tableaux de bord BI, renforçant ainsi la transparence et la confiance des métiers.

Points clés à retenir

- Les flux ETL sont la colonne vertébrale des projets BI.

- Les méthodes traditionnelles (Excel, fichiers manuels) sont insuffisantes.

- Le data mapping est une étape critique mais complexe.

- Les outils modernes de Metadata Management renforcent traçabilité, gouvernance et collaboration.

- Une gouvernance claire maximise la valeur et la confiance dans les données.