Les meilleurs outils de qualité des données en 2025 : comparaison et guide

La qualité des données est devenue un enjeu stratégique majeur à l’ère de l’IA et de la prise de décision en temps réel. Cet article présente les principaux outils de qualité des données en 2025, tels que SAP Data Services, Soda, Bigeye et DataGalaxy, et explique comment ils contribuent à renforcer la fiabilité, la conformité et la gouvernance des données dans les entreprises modernes.

Qu’est-ce que la qualité des données ?

La qualité des données désigne l’état d’un jeu de données selon plusieurs dimensions clés : exactitude, exhaustivité, cohérence, fiabilité et pertinence.

Des données de haute qualité sont indispensables pour une prise de décision efficace, une performance opérationnelle optimale et une conformité réglementaire. À l’inverse, une mauvaise qualité des données peut entraîner des erreurs d’analyse, des pertes financières et une dégradation de la réputation de l’entreprise.

Les principales dimensions de la qualité des données

- Exactitude : la mesure dans laquelle les données reflètent fidèlement les objets ou événements réels.

- Actualité (timeliness) : la mesure dans laquelle les données sont à jour et disponibles dans un délai utile.

- Exhaustivité : l’étendue à laquelle toutes les données requises sont présentes.

- Validité : la conformité des données à leur format, type et domaine de définition.

- Cohérence : l’absence de différences entre plusieurs représentations d’une même information.

- Unicité : la garantie que chaque enregistrement est représenté une seule fois.

Comment améliorer la qualité de ses données ?

L’amélioration de la qualité des données n’est pas un projet ponctuel, mais un processus continu et évolutif.

Voici les bonnes pratiques adoptées par les organisations les plus avancées :

1. Définir des métriques adaptées au contexte métier

Les critères de qualité varient selon les usages. Définissez ce qu’est une donnée « de qualité » pour chaque cas d’usage et chaque département.

2. Établir des niveaux de référence et des objectifs

On n’améliore que ce qu’on mesure. Commencez par évaluer votre niveau actuel, puis fixez des cibles réalistes d’amélioration.

3. Mettre en place des contrôles à chaque étape

Ne vous limitez pas aux tableaux de bord. Intégrez des contrôles de qualité dès la collecte, les processus ETL et la transformation des données.

4. Automatiser la surveillance et les tests

Les vérifications manuelles ne sont pas scalables. Les outils de qualité des données automatisent la détection d’erreurs et la validation continue des jeux de données.

5. Définir des responsabilités claires

Attribuez des responsables pour chaque domaine de données. Cela garantit un suivi efficace et limite les erreurs inattendues.

Comment surveiller la qualité des données ?

La gestion de la qualité des données (Data Quality Management, DQM) est une discipline qui veille à la précision, la fiabilité et l’utilisabilité des données.

Elle s’appuie sur des solutions avancées de data catalog, de gestion des métadonnées et de surveillance automatisée.

Le suivi de la qualité des données consiste à évaluer en continu les jeux de données selon des règles et des standards prédéfinis. Les outils modernes automatisent ces processus et génèrent des alertes en temps réel.

Étapes clés de la surveillance de la qualité des données

- Profilage (data profiling) : analyse de la structure, du contenu et des caractéristiques des données.

- Détection d’anomalies : identification de schémas ou valeurs inhabituels signalant des problèmes potentiels.

- Suivi et reporting : mesure continue des indicateurs de qualité et génération de rapports pour les parties prenantes.

- Validation : vérification de la conformité et de l’exactitude des données selon des règles métiers.

- Nettoyage (data cleansing) : correction ou suppression des données erronées, incomplètes ou dupliquées.

Les meilleures plateformes de qualité des données en 2025

SAP Data Services

SAP Data Services est un outil complet d’intégration et de transformation des données, conçu pour améliorer la qualité des données à l’échelle de l’entreprise.

Fonctionnalités clés :

- Intégration de données depuis diverses sources (SAP et non-SAP).

- Nettoyage et harmonisation des données pour garantir leur cohérence et leur exactitude.

- Profilage des données pour identifier les problèmes et tendances de qualité.

Soda

Soda est une plateforme moderne de qualité des données qui permet aux équipes data de détecter, prévenir et résoudre les problèmes de qualité de manière proactive.

Elle combine surveillance automatisée et collaboration entre les producteurs et consommateurs de données.

Fonctionnalités clés :

- Surveillance continue des pipelines de données pour repérer les anomalies.

- SodaCL, un langage dédié (domain-specific language) pour définir des tests de qualité lisibles par l’humain.

- Contrats de données collaboratifs, qui alignent les attentes entre équipes productrices et consommatrices de données.

Bigeye

Bigeye est une plateforme d’observabilité des données (data observability) de niveau entreprise, aidant les équipes à fiabiliser leurs données utilisées pour l’analytique, le reporting ou le machine learning.

Elle combine data lineage, détection d’anomalies, règles de qualité, réconciliation, et gestion d’incidents dans un environnement unifié.

Fonctionnalités clés :

- Surveillance automatisée des pipelines (fraîcheur, volume, schéma).

- Gestion centralisée des incidents de qualité.

- Intégration avec les outils de Business Intelligence pour assurer la fiabilité du reporting.

DataGalaxy : unifier qualité et gouvernance des données

Pour les responsables de la gouvernance et de la gestion des données, il devient essentiel d’adopter une approche intégrée alliant qualité, gouvernance, traçabilité et collaboration.

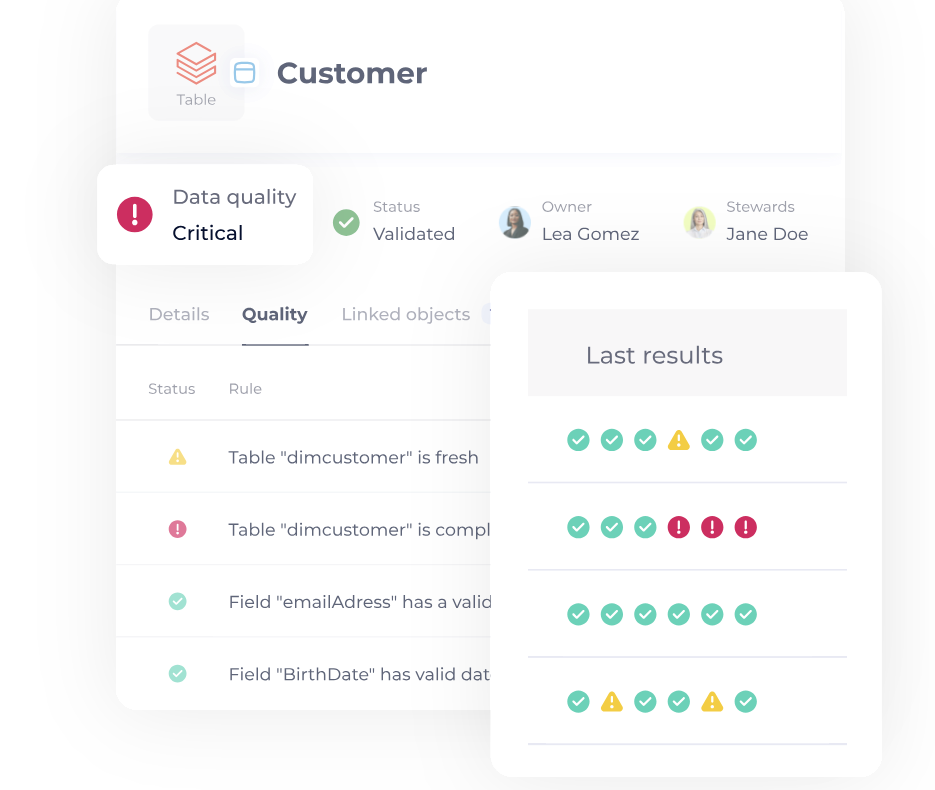

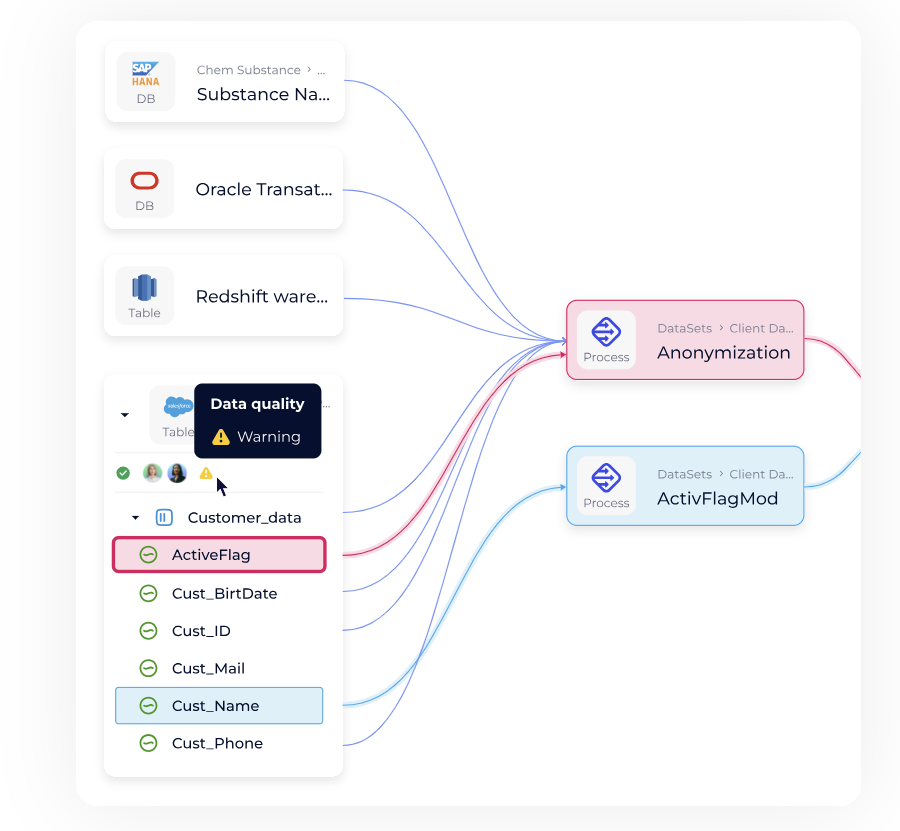

DataGalaxy est une plateforme de Data & AI Governance qui intègre la surveillance de la qualité des données au sein d’un écosystème complet dédié à la compréhension, la collaboration et la valorisation des actifs data.

Les bénéfices de DataGalaxy

- Visibilité complète : vision centralisée des actifs de données, de leur qualité et de leurs relations.

- Collaboration renforcée : documentation partagée entre producteurs et consommateurs de données.

- Conformité réglementaire : suivi de la traçabilité (data lineage) et des indicateurs de qualité pour répondre aux exigences du RGPD, HIPAA ou BCBS 239.

- Décision accélérée : fiabilisation des analyses et rapports pour des décisions éclairées.

En intégrant la qualité des données dans un cadre de gouvernance complet, DataGalaxy aide les organisations à transformer leurs données en un actif fiable et stratégique.

Conclusion

À l’heure où les entreprises basent leurs décisions sur les données, la qualité des données est un pilier de la performance et de l’innovation.

Des outils comme SAP Data Services, Soda et Bigeye répondent à des besoins spécifiques de surveillance et de fiabilisation.

Cependant, les regrouper dans une approche unifiée de gouvernance des données, comme le propose DataGalaxy, permet de maximiser la valeur des données et de renforcer la confiance dans chaque décision.

FAQ

- Pourquoi la qualité des données est-elle si importante ?

-

Des données inexactes entraînent de mauvaises décisions et une perte de confiance. La Data Quality est donc un pilier de toute stratégie Data Driven.

- Quelle est la différence entre data quality et data observabilité ?

-

La data quality mesure la fiabilité intrinsèque des données (exactitude, complétude, cohérence). La data observabilité surveille les flux de données en continu pour détecter rapidement anomalies et dérives avant qu’elles n’affectent la qualité et les usages métiers.

- Quels sont les meilleurs outils en 2025 ?

-

SAP Data Services, Soda, Bigeye et DataGalaxy figurent parmi les plus complets selon les cas d’usage.

- Comment intégrer la qualité des données à ma gouvernance ?

-

En centralisant vos outils de catalogage, de traçabilité et de qualité dans une même plateforme comme DataGalaxy.

Points clés à retenir

- La qualité des données est un enjeu stratégique au cœur de la gouvernance.

- Les outils de 2025 combinent automatisation, observabilité et collaboration.

- DataGalaxy se distingue par son approche unifiée de la qualité et de la gouvernance des données.

- Une bonne gestion de la qualité des données favorise la conformité, la performance et la fiabilité décisionnelle.