Gestion des risques liés à l’IA : comment surveiller et contrôler les systèmes d’IA

La gestion des risques liés à l’IA est devenue un enjeu stratégique pour toutes les organisations utilisant l’intelligence artificielle.

Sans supervision rigoureuse, les modèles peuvent produire des résultats biaisés, perdre en précision ou enfreindre des réglementations comme le RGPD ou l’AI Act européen.

Qu’est-ce que la gestion des risques liés à l’IA ?

La gestion des risques liés à l’IA vise à empêcher que de petits problèmes de modèles ne se transforment en incidents majeurs.

C’est un processus continu qui consiste à identifier, évaluer et traiter les risques lors de la conception, du déploiement et de la montée en charge des systèmes d’IA.

Une simple révision ponctuelle ou une politique générale ne suffisent pas : la gestion des risques doit être proactive et persistante, afin de maintenir les modèles alignés, réactifs et sous contrôle, même lorsque les conditions évoluent.

Les 5 risques majeurs à surveiller dans l’IA

Les risques peuvent être techniques ou opérationnels, mais tous peuvent nuire à votre organisation s’ils ne sont pas anticipés.

1. Risques liés aux données

Des données de mauvaise qualité entraînent inévitablement une IA défaillante. Erreurs, biais cachés, violations de la vie privée et absence de traçabilité peuvent altérer le comportement d’un modèle.

Exemple

un modèle d’octroi de crédit entraîné sur des données obsolètes peut mal évaluer la solvabilité et accorder des prêts à risque.

Bonnes pratiques

- Contrôles qualité automatisés avec Great Expectations ou TensorFlow Data Validation

- Suivi de la fraîcheur et des schémas via Monte Carlo ou Databand

2. Risques liés aux modèles

Même un modèle performant finit par perdre en pertinence. Dérive des données, surapprentissage, ou dépendance à des schémas qui ne sont plus valables peuvent réduire la précision des prédictions au fil du temps.

Exemple

Un modèle de détection de fraude qui, après quelques mois, signale de vraies transactions comme suspectes et laisse passer des fraudes réelles.

Bonnes pratiques

- Monitoring en continu avec Evidently AI ou Arize AI

- Réentraînement planifié et tests de régression

3. Risques opérationnels

Un modèle performant en laboratoire ne garantit pas un succès en production.

Parmi les causes fréquentes :

- Blocages lors du passage entre équipes data science et ingénierie

- Latence excessive en temps réel

- Échecs d’intégration liés à des API instables ou des workflows incomplets

Bonnes pratiques

- Pipelines CI/CD dédiés à l’IA avec MLflow ou Kubeflow

- Tests de charge et simulation en préproduction

4. Risques éthiques & sociaux

Des décisions biaisées peuvent exclure des candidats, refuser un crédit ou un accès à des services essentiels.

Manque de transparence, absence d’explicabilité, données d’entraînement déséquilibrées… Les impacts dépassent la simple performance technique et peuvent mener à des scandales publics et à une perte de réputation.

Bonnes pratiques

- Audit d’équité avec Aequitas ou IBM AI Fairness 360

- Explicabilité via SHAP, LIME ou InterpretML

5. Risques réglementaires

Les réglementations comme l’AI Act (UE), le RGPD ou la HIPAA imposent désormais des obligations claires sur la transparence, la traçabilité et la gestion des risques.

Il ne suffit plus de fournir des résultats : il faut pouvoir démontrer comment et pourquoi l’IA prend ses décisions.

Bonnes pratiques

- Systèmes de data lineage intégrés comme OpenLineage ou DataGalaxy

- Gestion des accès basée sur les rôles (RBAC)

Bonne pratiques pour développer et maintenir vos data products

Dans ce guide, nous vous proposons une présentation complète afin de vous aider à faire face aux complexités du développement et du maintien de data products.

Téléchargez le livre blancComment surveiller & contrôler un système d’IA en production

Surveiller la performance en temps réel

Suivre des métriques clés : précision, rappel, dérive, latence.

Utiliser des tableaux de bord temps réel et des alertes automatiques pour détecter rapidement tout problème.

Réévaluer régulièrement

Un modèle performant au lancement peut être obsolète en six mois.

Planifier des revues régulières pour vérifier les hypothèses, tester les performances et aligner le modèle sur les objectifs métiers.

Détecter les biais et impacts inéquitables

Analyser les résultats par groupes démographiques pour identifier toute disparité.

Auditer les causes racines, notamment au niveau des variables ou données d’entraînement.

Journaliser les décisions et tracer les entrées

Conserver un historique complet des décisions : données d’entrée/sortie, logique de décision, messages d’erreur.

La traçabilité est essentielle pour les audits et la responsabilité.

Outils & frameworks essentiels pour la gestion des risques liés à l’IA

1. Plateformes de surveillance des modèles

Elles mesurent en continu précision, latence, dérive et anomalies.

Objectif : détecter et corriger avant que les utilisateurs ne subissent les conséquences.

Exempes: Arize AI, WhyLabs

2. Systèmes de traçabilité des données (data lineage)

Ils permettent de suivre le parcours complet des données, de l’ingestion à l’utilisation par le modèle. Idéal pour identifier rapidement la source d’un problème.

Exemples: OpenLineage, DataGalaxy

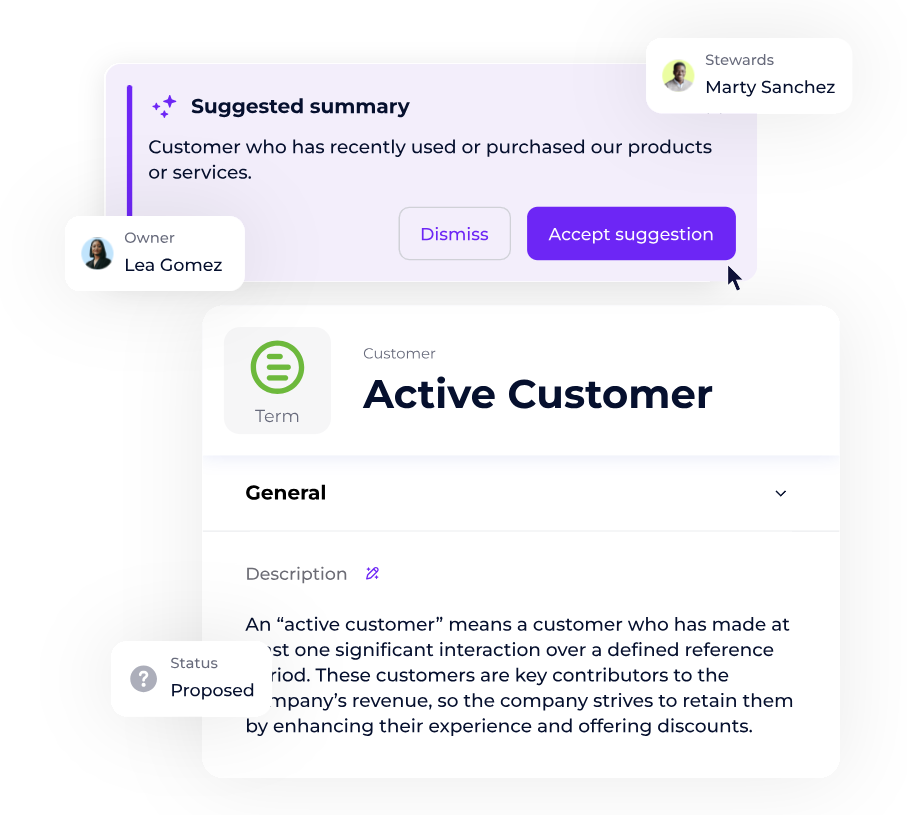

3. Frameworks de gouvernance

Une bonne gouvernance unifie définitions, usages des modèles et responsabilités.

onctionnalités clés :

- Workflows collaboratifs pour définir politiques et responsabilités

- Couche de métadonnées centralisée

- Contrôles d’accès basés sur les rôles

- Traçabilité automatisée des données

4. Outils d’observabilité des données

Ils détectent les problèmes en amont (fraîcheur, schémas, anomalies) avant qu’ils n’affectent les modèles.

Exemples: Monte Carlo, Databand

Maîtriser les risques pour créer de la valeur

L’IA offre vitesse, échelle et nouvelles opportunités.

Mais sans supervision claire, elle peut aussi générer incertitudes et risques majeurs.

En identifiant les points critiques, en intégrant les contrôles dans la production et en utilisant les bons outils, vous garantissez une IA performante, éthique et conforme.

FAQ

- Quels sont les principaux risques liés à l’IA ?

-

Les risques concernent la qualité des données, la performance des modèles, les problèmes opérationnels, les biais éthiques et le respect des réglementations.

- Pourquoi la supervision des systèmes d’IA est-elle essentielle ?

-

Elle permet de détecter rapidement les dérives, maintenir la précision des modèles et garantir une IA éthique et conforme aux lois en vigueur.

- Quels outils utiliser pour surveiller un modèle d’IA ?

-

Parmi les plus utilisés : Arize AI, WhyLabs, MLflow, Monte Carlo ou DataGalaxy, qui offrent monitoring, traçabilité et détection des anomalies.

- Comment détecter les biais dans un modèle d’IA ?

-

En analysant les résultats par groupe démographique, en auditant les données d’entraînement et en utilisant des outils comme SHAP ou AI Fairness 360.

- Quelles réglementations encadrent l’IA ?

-

Les plus connues incluent le RGPD en Europe, l’AI Act, la HIPAA pour la santé, ainsi que d’autres lois sectorielles ou locales sur la transparence et la traçabilité.

Points clés à retenir

- Les risques concernent les données, les modèles, l’exploitation, l’éthique et la réglementation

- La supervision doit être continue et proactive

- Des outils dédiés permettent de détecter, diagnostiquer et corriger rapidement

- Une IA bien gouvernée est un levier de valeur et de confiance