Data quality : définition, enjeux, et meilleures pratiques

La qualité des données (data quality) est un pilier stratégique pour toutes les entreprises data-driven.

Elle repose sur 6 dimensions fondamentales : exactitude, complétude, cohérence, unicité, actualité et validité.

Des données fiables réduisent les coûts, sécurisent la conformité (GDPR, HIPAA, BCBS 239, Solvabilité II), soutiennent l’innovation et garantissent des décisions justes.

Ce guide propose une vision complète de la data quality : définition, enjeux, risques, principes, méthodes, cadres réglementaires et cas d’usage concrets.

Qu’est-ce que la data quality et quelles sont ses dimensions clés ?

La Data Quality, ou qualité des données, désigne la capacité des données à être utilisées de manière fiable et efficace dans les processus de décision, de reporting, de conformité et d’innovation. Elle repose sur un ensemble de dimensions fondamentales qui permettent d’évaluer si une donnée est fiable, complète et exploitable.

- Exactitude : une donnée doit refléter fidèlement la réalité. Par exemple, une adresse email doit correspondre à la bonne personne, sans faute de saisie.

- Complétude : aucune information essentielle ne doit manquer. Un formulaire client sans numéro de téléphone ou sans code postal perd une partie de sa valeur.

- Cohérence : une donnée doit être identique et alignée d’un système à l’autre. Si la date de naissance d’un client diffère entre le CRM et l’ERP, la confiance est rompue.

- Unicité : éviter les doublons, qui entraînent confusion et surcoûts, notamment dans les campagnes marketing.

- Actualité : les données doivent être disponibles et à jour. Un stock obsolète ou une adresse erronée peut fausser la prise de décision.

- Validité : le format doit respecter les standards et règles définis (exemple : un numéro IBAN correctement structuré).

À retenir : Ces 6 dimensions sont la base de toute démarche de gestion de la qualité des données et permettent d’évaluer objectivement la fiabilité des actifs informationnels.

Pourquoi la qualité des données est-elle stratégique pour l’entreprise ?

DDans un monde data-driven, la qualité des données n’est pas un luxe : c’est une condition de survie et de croissance.

- Cartographie des données : une cartographie claire des flux et des sources de données est indispensable pour éviter les silos, réduire les incohérences et sécuriser la gouvernance globale.

- Décisions fiables : les données sont le socle des choix stratégiques. Une information inexacte peut conduire à une erreur coûteuse, comme le lancement d’un produit sur un marché mal ciblé.

- Optimisation business : des données complètes permettent de mieux comprendre les clients, d’identifier de nouvelles opportunités et d’accroître la performance commerciale.

- Conformité réglementaire : les réglementations comme le GDPR, HIPAA ou BCBS 239 exigent une traçabilité et une fiabilité irréprochables.

- Innovation et IA : sans données fiables et bien structurées, les projets analytiques ou d’intelligence artificielle échouent rapidement.

Selon Gartner, les organisations perdent en moyenne 12,9 millions de dollars par an à cause d’une mauvaise qualité des données. Cet impact économique illustre combien la Data Quality est un prérequis stratégique pour toute entreprise data-driven.

À retenir : La data quality conditionne la réussite des projets de transformation, d’IA et de gouvernance des données.

Les 3 KPI pour générer une réelle valeur

Découvrez rapidement les trois meilleures façons de mesurer le succès et de faire une réelle différence dans votre organisation.

Téléchargez le livre blanc

Quels sont les risques et coûts d’une mauvaise data quality ?

La mauvaise qualité des données est un poison silencieux pour les organisations. Elle engendre des coûts cachés, une perte de productivité et un risque élevé de non-conformité.

- Temps perdu : les équipes passent des heures à corriger, vérifier ou rechercher des données manquantes.

- Décisions biaisées : une donnée incorrecte peut mener à des analyses erronées et à des choix financiers risqués.

- Opportunités manquées : des informations incomplètes empêchent de cibler les bons clients ou de détecter des tendances de marché.

- Non-conformité : des données non conformes aux réglementations peuvent entraîner amendes, audits coûteux et perte de crédibilité.

- Risque réputationnel : un rapport erroné envoyé à un régulateur ou une erreur dans une communication client peut nuire durablement à la confiance.

Selon DAMA-DMBOK, les problèmes les plus fréquents incluent : données inexactes, perte de contexte, définitions floues, redondances et incohérences.

À retenir : Les entreprises qui négligent la qualité des données s’exposent à des pertes financières et à une perte de compétitivité.

Quels sont les 7 principes pour gérer efficacement la data quality ?

Une démarche robuste repose sur 7 principes structurants :

- Impliquer toutes les parties prenantes : la Data Quality concerne autant les métiers que l’IT. Impliquer les utilisateurs finaux permet d’ancrer la démarche dans le quotidien.

- Adopter une approche processus : documenter la création, la modification et l’usage des données évite les zones d’ombre et facilite la traçabilité.

- S’aligner sur les besoins métiers : la qualité des données doit servir des objectifs business concrets (meilleure satisfaction client, optimisation des ventes, conformité).

- Assurer un leadership clair : définir des rôles (Chief Data Officer, Data Steward) pour éviter la dilution des responsabilités.

- Instaurer une amélioration continue : la qualité n’est jamais acquise, elle doit évoluer avec les systèmes et les besoins de l’entreprise.

- Prendre des décisions pilotées par la donnée : mettre en place des indicateurs et des tableaux de bord pour mesurer et piloter en continu.

- Gérer tout le cycle de vie : de la collecte à l’archivage ou suppression, chaque étape doit respecter les règles de Data Quality.

À retenir : Ces principes constituent une méthodologie éprouvée pour instaurer une culture data quality pérenne.

Quels outils et méthodes permettent d’améliorer la data quality ?

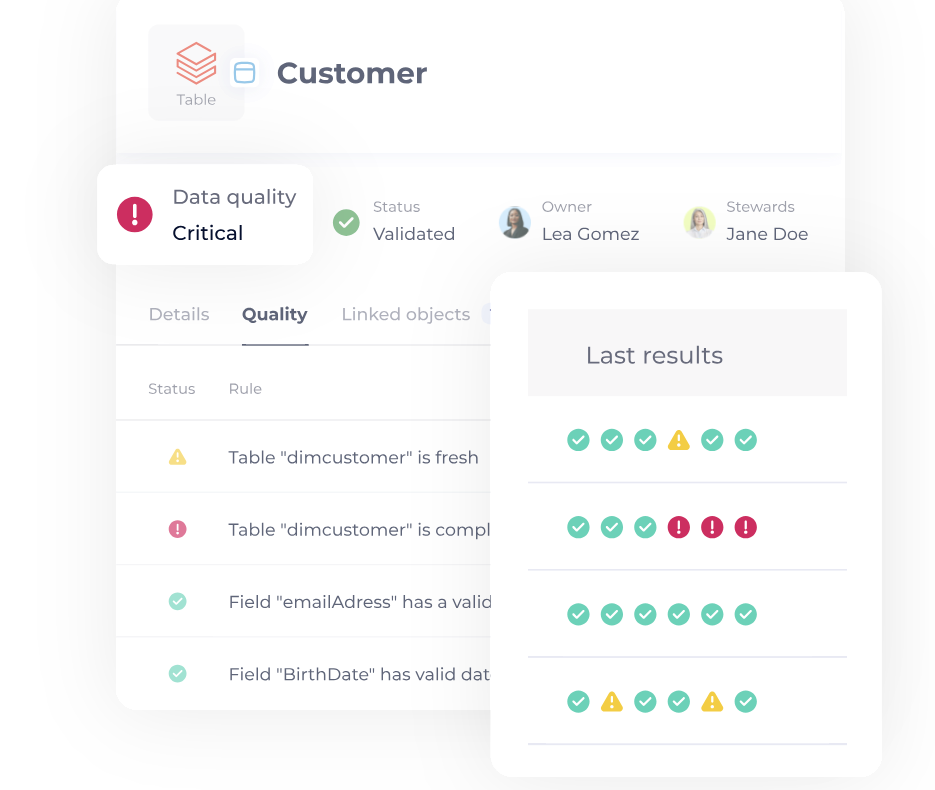

Les entreprises s’appuient sur différents leviers technologiques et organisationnels :

- Outils spécialisés (Informatica, Talend, Ataccama, Collibra) pour contrôler l’exactitude et éliminer les doublons,

- Data Catalogs modernes (ex. DataGalaxy) pour documenter et centraliser les règles,

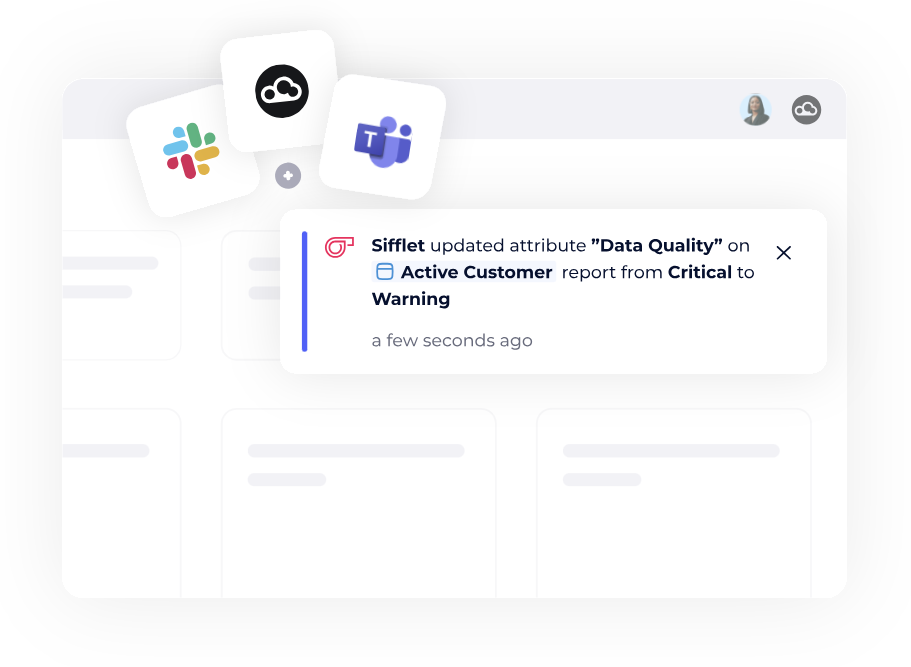

- Automatisation et monitoring en temps réel avec alertes,

- Workflows collaboratifs pour impliquer métiers et IT.

À retenir : Les outils de data quality et de data catalog permettent d’automatiser, monitorer et centraliser la gouvernance des données.

Quels cadres et réglementations encadrent la data quality ?

La data quality est encadrée par des référentiels et normes internationaux :

- ISO 8000 (qualité des données),

- DAMA-DMBOK (Data Management Body of Knowledge).

Et par des réglementations sectorielles :

- GDPR (Europe, protection des données personnelles),

- HIPAA (États-Unis, confidentialité des données de santé),

- BCBS 239 (banques, reporting de risque),

- Solvabilité II (assurance).

À retenir : Ces cadres exigent traçabilité, documentation et contrôle de bout en bout.

Bonne pratiques pour développer et maintenir vos data products

Dans ce guide, nous vous proposons une présentation complète afin de vous aider à faire face aux complexités du développement et du maintien de data products.

Téléchargez le livre blancQuels sont les cas d’usage concrets de la data quality ?

La Data Quality n’est pas un concept théorique : elle a un impact direct sur le quotidien des entreprises.

- Marketing et relation client : suppression des doublons dans une base CRM pour éviter d’envoyer plusieurs fois la même campagne à un prospect, et améliorer le ROI.

- Conformité réglementaire : mise en place de règles automatiques de validation pour garantir le respect du GDPR et éviter les sanctions.

- Intelligence artificielle et Machine Learning : constitution de jeux de données propres, représentatifs et équilibrés pour entraîner des modèles prédictifs fiables.

- Pilotage business : calcul de KPIs financiers et opérationnels basés sur des données consolidées, permettant de démontrer la valeur créée par la Data Quality.

- Cartographie et gouvernance : centralisation des flux de données dans un Data Catalog pour mieux comprendre les interdépendances entre systèmes.

À retenir : Les cas d’usage illustrent le lien direct entre data quality et valeur business.

Conclusion

La data quality est un avantage concurrentiel durable. Elle réduit les coûts, améliore la prise de décision, soutient l’innovation et garantit la conformité réglementaire.

Ne laissez pas des données de mauvaise qualité compromettre vos projets.

Découvrez comment DataGalaxy peut vous aider à instaurer une data & AI product governance solide et efficace.

FAQ

- Qu’est-ce que la Data Quality ?

-

La Data Quality désigne l’ensemble des caractéristiques qui déterminent si une donnée est exacte, complète, cohérente, valide, unique et à jour.

Elle ne se limite pas à l’absence d’erreurs : elle mesure la capacité des données à soutenir les objectifs métier, réglementaires et analytiques de l’organisation. - Quels outils pour suivre la Data Quality ?

-

Un Data Catalog enrichi d’indicateurs de qualité, de workflows de validation, et de connecteurs aux systèmes sources.

- Quelle est la différence entre Data Quality et Data Governance ?

-

Data Governance : définit les règles, rôles et responsabilités pour gérer l’ensemble des données d’une organisation.

Data Quality : se concentre sur l’exactitude, la complétude, la cohérence et la fiabilité des données utilisées dans les processus métiers et l’IA.

- Combien de temps faut-il pour mettre en place une stratégie Data Quality efficace ?

-

Généralement 3 à 12 mois, selon :

– la taille de l’organisation,

– la complexité des systèmes d’information,

– le niveau de maturité data existant.

Points clés à retenir

- La Data Quality repose sur 6 dimensions fondamentales.

- Des données fiables = des décisions fiables, moins de coûts et plus de valeur business.

- Les 7 principes structurent une méthodologie éprouvée de gestion.

- Les outils (Informatica, Talend, Collibra, DataGalaxy) et Data Catalogs centralisent la gestion.

- La Data Quality est un pilier stratégique de la Data Governance et de l’IA.

Pour aller plus loin

La data quality est un sujet vaste qui se décline en de nombreux axes complémentaires.

Pour approfondir certains aspects précis, découvrez nos articles dédiés :

- Cartographie des données : quoi, pourquoi et comment ?

Découvrez comment cartographier vos données permet de mieux les comprendre, de limiter les silos et d’améliorer leur qualité globale. - Les 7 principes de gestion de la qualité des données

Un guide pratique pour mettre en place une démarche structurée et durable de gestion de la data quality. - Comment créer des règles de data quality efficaces ?

Apprenez à définir des règles adaptées à vos cas d’usage et à les intégrer dans vos processus de gouvernance. - 5 raisons de connecter votre gouvernance des données à un véritable outil de qualité

Pourquoir connecter votre gouvernance à un outil. - Les meilleurs outils de qualité des données en 2025 : comparaison et guide

Panorama des solutions et critères pour choisir l’outil adapté à vos besoins. - Mauvaise qualité des données : impacts et risques

Un focus sur les conséquences concrètes et les pièges à éviter. - Data Governance et Data Quality : différences et complémentarités

Comprendre comment la gouvernance structure la démarche qualité et pourquoi elles sont indissociables.