Construire un cadre de qualité des données évolutif : les 4 meilleures pratiques

À mesure que les entreprises grandissent et que leurs écosystèmes de données se complexifient, maintenir la qualité des données devient un défi stratégique. Un simple nettoyage ponctuel ne suffit plus : il faut un cadre de qualité des données capable d’évoluer avec le volume, la diversité et les usages.

Cet article présente une architecture modulaire, gouvernée et automatisée, illustrant comment garantir des données fiables à grande échelle. Découvrez les principes fondamentaux, les composants clés et les bonnes pratiques pour bâtir un cadre durable et scalable.

Qu’entend-on vraiment par qualité des données ?

La qualité des données ne se résume pas à des tableaux propres ou à des formats uniformes. Elle désigne la capacité des données à remplir efficacement leur rôle dans vos processus, décisions et opérations.

Une donnée de qualité soutient les objectifs métier, alimente les analyses avec précision et inspire la confiance. Pourtant, à mesure que les volumes et les sources se multiplient, des problèmes insidieux apparaissent et minent progressivement la fiabilité du système.

Problèmes courants de qualité des données : 5 erreurs à surveiller

- Incohérence : valeurs contradictoires rendant la réconciliation impossible

- Duplication : enregistrements multiples faussant les métriques

- Obsolescence : informations périmées réduisant leur utilité

- Inexactitude : écart entre les données collectées et la réalité

- Incomplétude : champs vides limitant la valeur analytique

Ces défauts, s’ils ne sont pas détectés, peuvent fausser les modèles d’IA, dégrader les dashboards et semer la méfiance.

Un cadre robuste permet de prévenir, détecter et corriger ces problèmes à mesure que la complexité croît.

À retenir

La qualité des données est une discipline proactive.

Plus vos données se diversifient, plus le risque d’erreur augmente d’où l’importance d’une infrastructure d’observabilité continue.

Les 4 principes d’un cadre de qualité des données évolutif et durable

Principe 1 : adopter une architecture modulaire et flexible

Les architectures monolithiques se fissurent sous la pression.

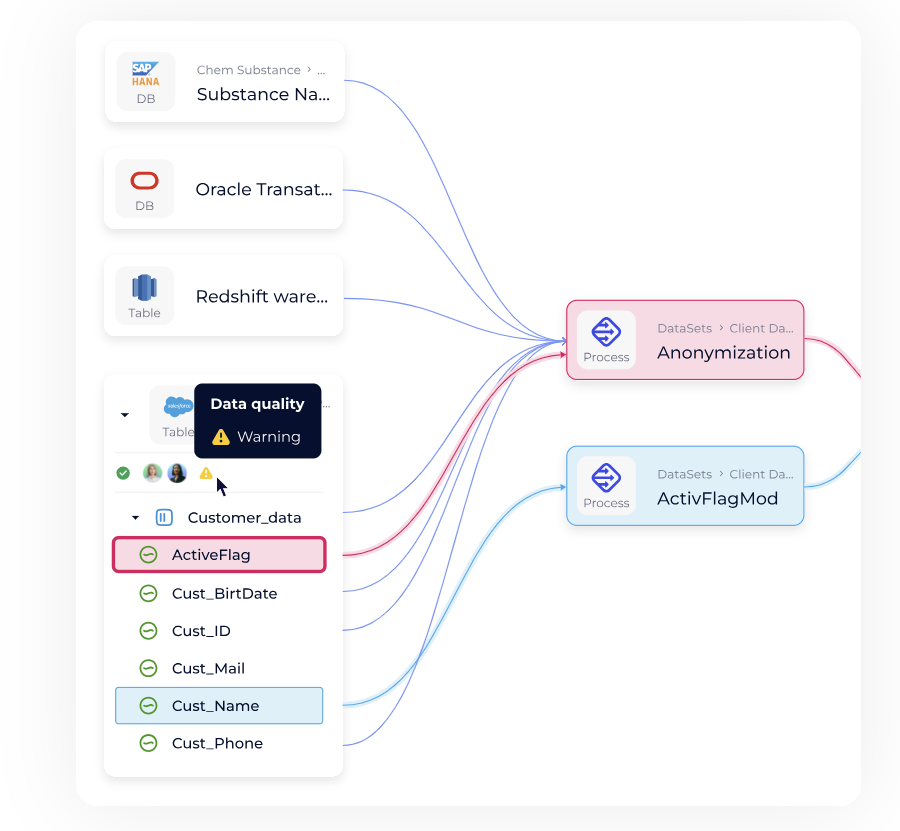

Les architectures modulaires et interopérables (par ex. Snowflake, DataGalaxy, dbt) permettent de séparer les contrôles qualité et d’intégrer de nouveaux pipelines sans refonte globale.

Clés de succès :

- Découpler les contrôles qualité du code applicatif

- Favoriser l’interopérabilité entre outils et équipes

- Automatiser les validations pour accompagner la croissance

Principe 2 : surveiller les données en continu

La vérification ponctuelle ne suffit plus : il faut une surveillance continue.

Les solutions d’observabilité (Monte Carlo Data, Bigeye, Databand) permettent d’identifier les anomalies en temps réel et de rediriger les incidents vers les bons référents.

Bonnes pratiques :

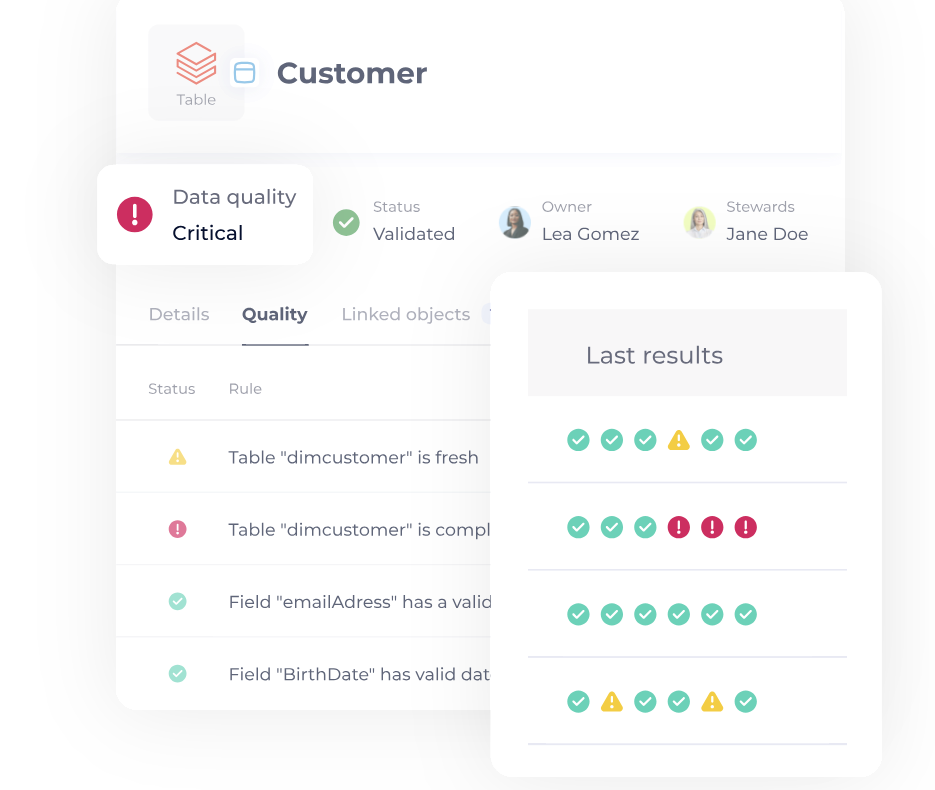

- Détection d’anomalies et alertes intelligentes

- Validation à l’ingestion pour bloquer les données corrompues

- Routage automatique vers les bons owners

Principe 3 : instaurer une gouvernance proactive

Une gouvernance moderne repose sur la responsabilité, la traçabilité et la transparence.

Les data stewards et owners doivent disposer de politiques dynamiques et d’outils de suivi (ex. Collibra, Ataccama, DataGalaxy).

À mettre en place :

- Attribution claire des responsabilités

- Règles automatisées liées aux politiques

- Journalisation complète du lineage et des transformations

Principe 4 : renforcer la responsabilité et la culture data

La qualité n’est pas qu’une question d’outils : c’est une question d’accountability.

Chaque équipe doit comprendre comment ses actions impactent la fiabilité des données.

Il faut :

- Fournir aux équipes locales les outils et formations adaptés

- Promouvoir un langage commun autour de la qualité des données

- Aligner les indicateurs qualité sur des résultats métier tangibles

À retenir :

- Architecture modulaire

- Monitoring continu

- Gouvernance proactive

- Responsabilisation distribuée

Ces quatre leviers forment la base d’un cadre scalable et résilient.

Les composants essentiels d’un cadre de qualité des données évolutif

1. Évaluer la qualité des données avec des indicateurs standardisés

Impossible d’améliorer ce qu’on ne mesure pas.

Évaluez vos données selon les dimensions ISO 8000 : exactitude, complétude, cohérence, actualité, unicité.

- Définissez des indicateurs de référence (KPI) alignés sur les besoins métiers

- Utilisez des modèles de scoring pondérés pour hiérarchiser les priorités

- Suivez les évolutions dans le temps pour identifier les tendances

L’évaluation transforme la notion floue de “qualité” en performance mesurable.

2. Intégrer les contrôles qualité dans le cycle de vie des données

Les contrôles qualité ne doivent pas être isolés : ils doivent être intégrés tout au long du cycle de vie des données. Par exemple, via des validations dans Airflow, dbt tests ou des scripts Great Expectations.

- Validez les données à chaque point d’entrée

- Appliquez automatiquement les règles de qualité dans les workflows

- Assurez la compatibilité entre plateformes, outils et équipes

Objectif : empêcher la propagation de données erronées avant qu’elles n’affectent les systèmes aval.

3. Mettre en place un reporting clair sur la qualité

Sans visibilité, il n’y a pas d’amélioration.

Le reporting doit offrir une vision transparente de l’état de la qualité et de l’efficacité des processus.

- Créez des tableaux de bord dédiés aux data stewards, ingénieurs et métiers

- Configurez des alertes automatiques pour signaler les problèmes émergents

- Partagez les tendances et progrès avec les parties prenantes

La transparence alimente la responsabilité et renforce la culture de la qualité.

4. Faire évoluer le cadre dans le temps

Un cadre efficace aujourd’hui peut devenir obsolète demain.

Anticiper l’évolution des usages et technologies est la clé.

- Automatisez pour éliminer les goulots d’étranglement manuels

- Rendez les règles et logiques réutilisables entre équipes

- Concevez des modèles de gouvernance adaptables à de nouvelles sources

Astuce IA : pensez à intégrer un moteur de règles piloté par IA pour adapter vos contrôles selon le contexte ou l’usage

Pensez la scalabilité non pas comme un futur projet, mais comme une exigence immédiate.

Bonnes pratiques pour déployer un cadre de qualité des données réussi

Même le meilleur design échoue sans une mise en œuvre réfléchie.

Voici comment déployer votre cadre avec succès.

Aligner le cadre sur les indicateurs métiers

Un cadre évolutif commence par une clarté d’objectifs : pourquoi la qualité compte.

Reliez vos initiatives à des KPI métiers tels que la satisfaction client, la conformité réglementaire, la précision des modèles d’IA ou l’efficacité opérationnelle.

Quand les métriques de qualité servent directement les objectifs business, il devient plus facile de convaincre, mesurer et investir durablement.

Commencer petit, évoluer intelligemment

Tenter de résoudre tous les problèmes de données d’un coup mène à l’échec.

Misez sur un cas d’usage à fort impact pour prouver rapidement la valeur du cadre.

Obtenez des succès visibles, capitalisez sur les apprentissages, puis étendez progressivement à d’autres domaines.

Capitaliser sur les outils existants

Un bon cadre s’appuie sur l’existant.

Réutilisez vos outils de monitoring, de gouvernance et de validation déjà en place.

Les meilleurs frameworks s’intègrent dans votre écosystème, sans imposer un nouvel outil à vos équipes.

Comblez les lacunes avec des solutions automatisables prenant en charge la traçabilité, les métadonnées et la validation de la qualité.

Erreurs courantes à éviter

Même les projets les mieux intentionnés peuvent échouer si certains écueils ne sont pas anticipés.

Ne pas surveiller en temps réel

Vérifier la qualité des données une fois par an ou après une crise, c’est déjà trop tard.

Le suivi en continu avec alertes automatisées permet d’intervenir avant que les problèmes ne deviennent systémiques.

Ignorer le contexte métier

Des règles de qualité déconnectées des besoins réels gaspillent du temps et créent de la frustration.

Une donnée peut être techniquement “propre” mais inutile pour les opérations.

Assurez-vous que votre cadre reflète les usages métier et leurs priorités.

Appliquer les mêmes règles partout

Chaque domaine, marketing, finance, opérations, a ses propres exigences.

Un cadre évolutif doit permettre une personnalisation locale au sein d’une approche globale cohérente.

Éviter ces pièges, c’est protéger la confiance dans vos données à mesure que votre organisation grandit.

Construire le cadre dont votre futur a besoin

Votre volume de données explose. Leur vitesse, leur complexité et leur rôle central augmentent.

Sans un cadre solide, cette croissance conduit inévitablement à la confusion, à la perte d’efficacité et à la méfiance.

Un cadre de qualité des données évolutif crée la clarté.

Il offre à vos équipes la structure, les standards et la responsabilité nécessaires pour fournir des insights fiables à grande échelle.

Concevez un cadre prêt à évoluer avec votre entreprise et avec l’avenir de vos données.

FAQ

- Qu’est-ce qu’un cadre de qualité des données ?

-

Un cadre de qualité des données est un ensemble de processus, outils et règles destinés à maintenir la fiabilité, la cohérence et la traçabilité des données à chaque étape de leur cycle de vie. Il permet d’identifier, corriger et prévenir les erreurs à grande échelle.

- Pourquoi un cadre évolutif est-il essentiel ?

-

Parce que les volumes, les sources et les usages des données évoluent constamment. Un cadre scalable garantit la stabilité de la qualité malgré la croissance et la complexité croissante de l’écosystème data. Il soutient directement la gouvernance et la confiance dans les décisions basées sur les données.

- Quels sont les principaux indicateurs pour mesurer la qualité des données ?

-

Taux d’exactitude (Accuracy Rate)

Taux de complétude (Completeness Rate)

Taux d’anomalies détectées

Temps moyen de correction (Mean Time to Repair – MTTR)

Indice de conformité réglementaire (RGPD, HIPAA, CCPA, BCBS 239) - Quelles erreurs éviter lors du déploiement d’un cadre de qualité ?

-

Ne pas surveiller les données en continu

Déconnecter les règles de la réalité métier

Uniformiser les règles sans tenir compte des contextes locaux

Négliger la formation et la responsabilisation des data owners

L’échec vient souvent d’un manque de gouvernance partagée plutôt que d’un manque d’outils.

- Comment intégrer la qualité des données à ma gouvernance ?

-

En centralisant vos outils de catalogage, de traçabilité et de qualité dans une même plateforme comme DataGalaxy.

Points clés à retenir

- Scalabilité avant tout : un cadre moderne doit être modulaire et flexible pour suivre la complexité croissante des données.

- Prévention plutôt que correction : la surveillance continue et la gouvernance proactive préviennent les dérives.

- Alignement métier : relier les indicateurs de qualité aux résultats business garantit l’adhésion et la pérennité du cadre.